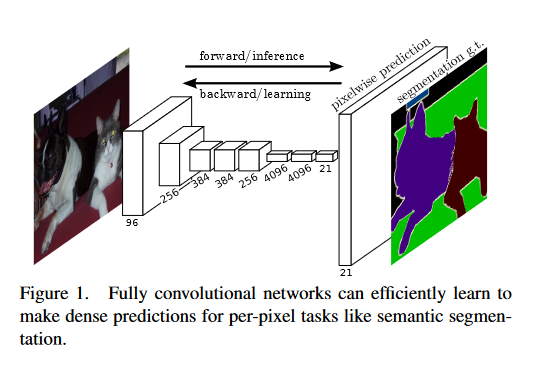

Semantic Segmentation

- predict pixel-wise labels, given a pre-defined set of categories

- 각각의 픽셀이 어느 카테고리에 해당하는가?

- does not differentiate instances, only case about pixels

Fully Convolutional Networks

- 기존 cnn과 다른 점은 출력 층의 크기가 입력과 같아야 한다.

- upsampling 이 필요하다.

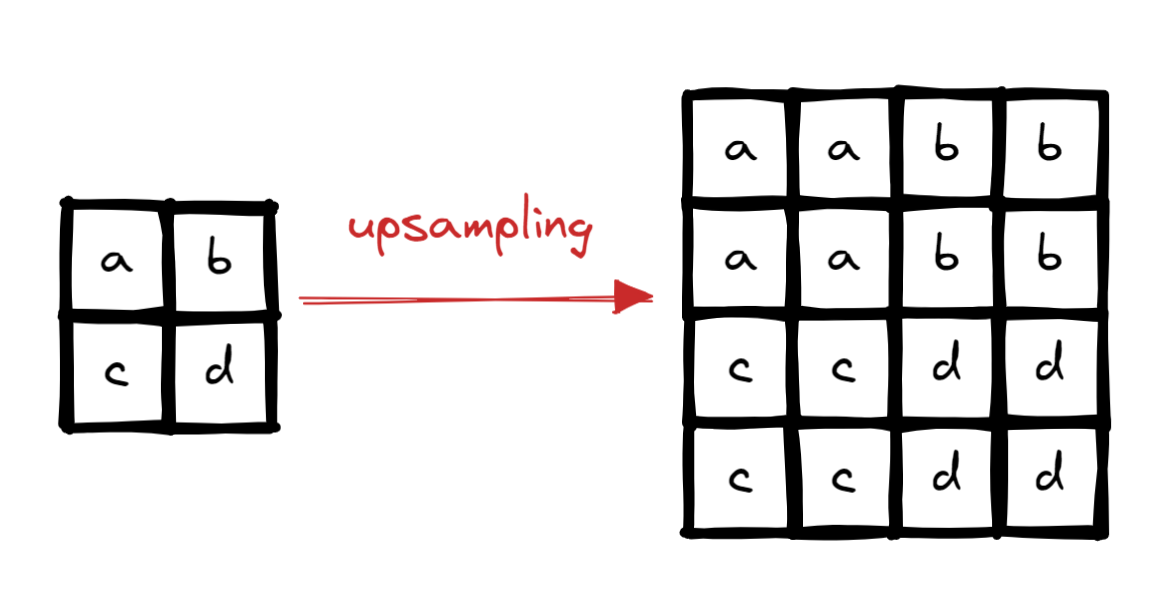

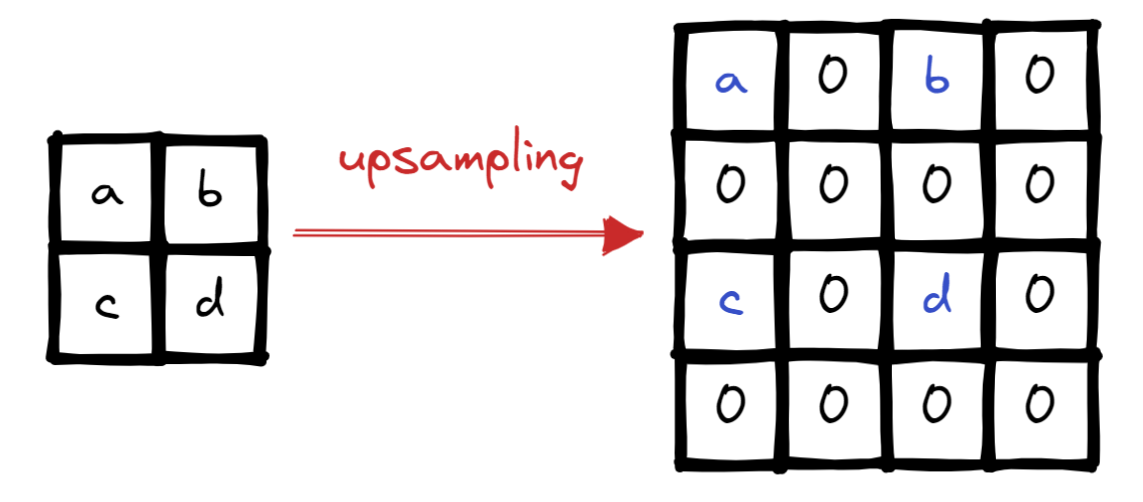

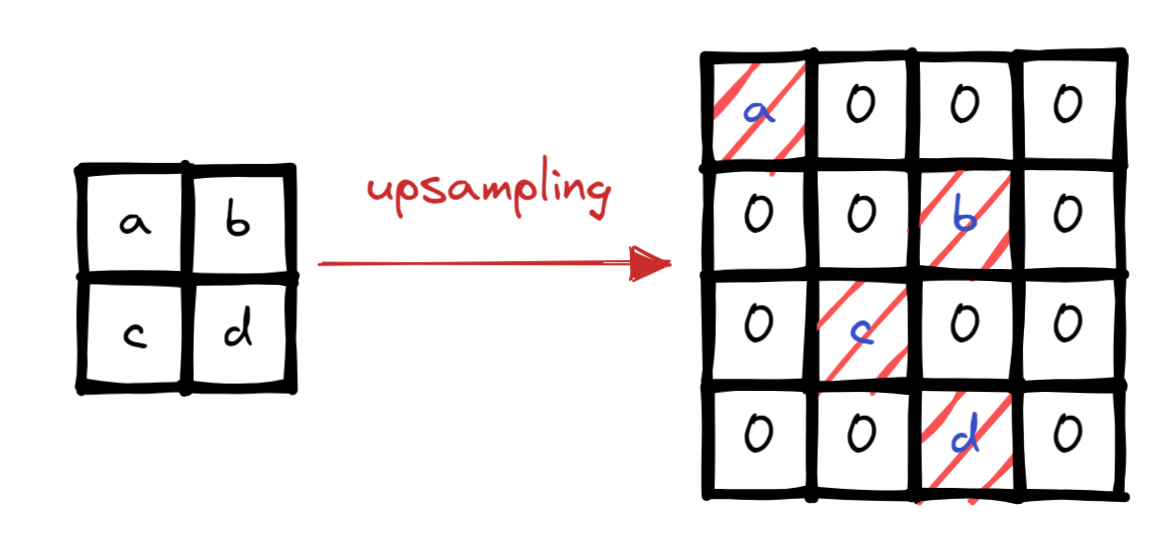

Upsampling

- upsampling 하는 방법을 알아보자

Nearest Neighbor

Bed of Nails

Max pooling

- 이전 pooling 과정에서 max값을 찾은 위치를 기억하고 upsampling할 때 그 위치로 값을 배치한다.

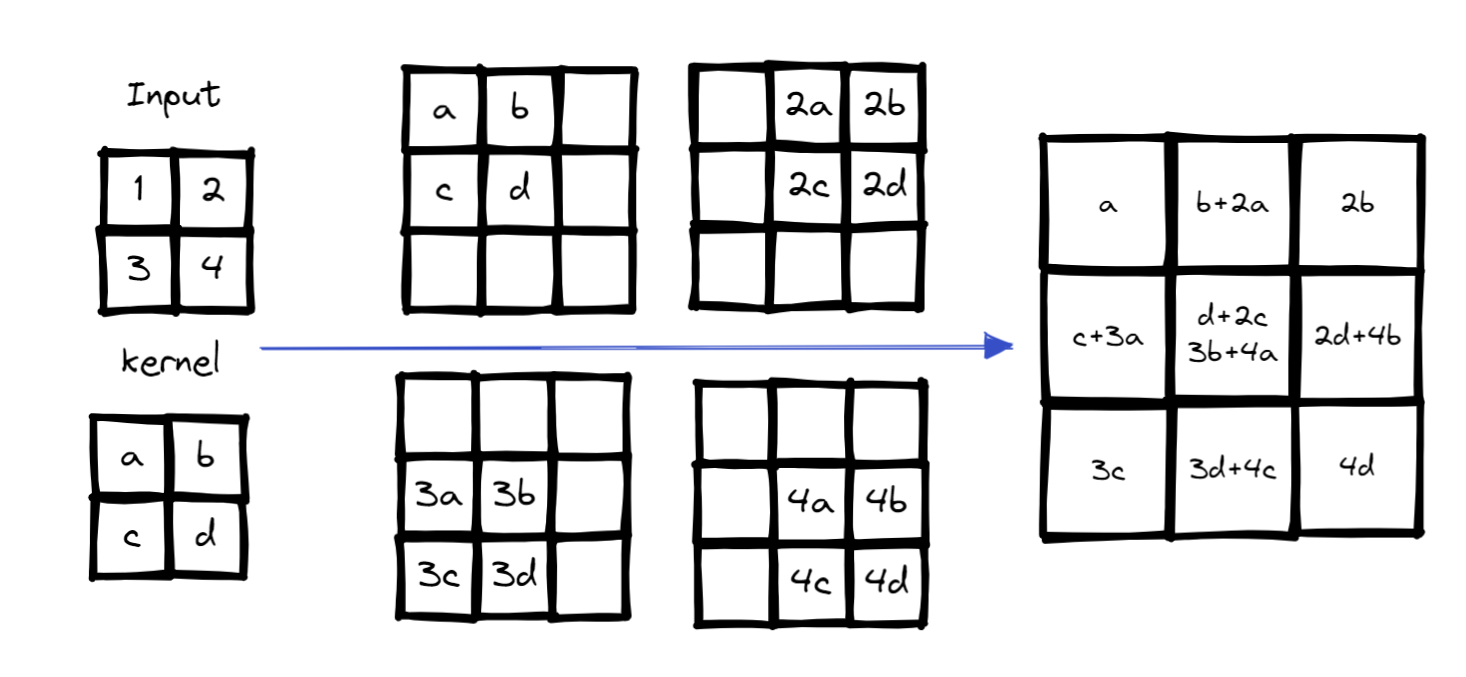

Deconvolution or Transposed Convolution

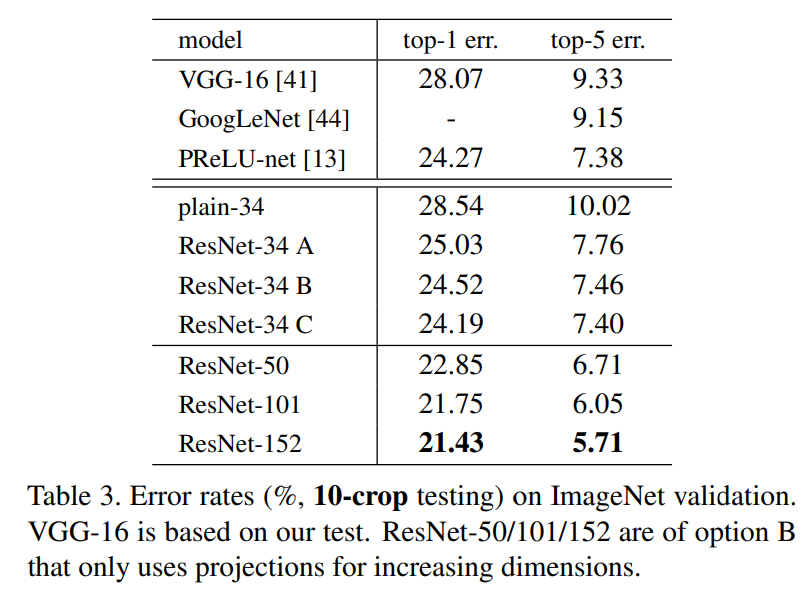

ResNet

출처 : Deep Residual Learning for Image Recognition

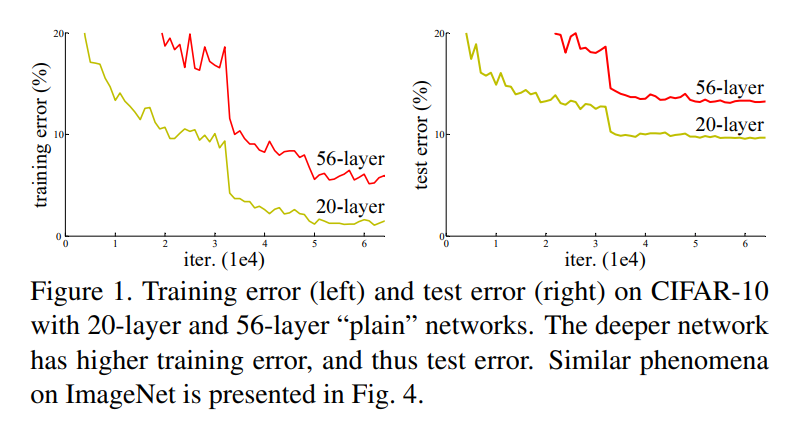

모델들이 깊어질 수록 효과가 좋아진다 생각함

- 얼마나 깊어져야 하는가?

논문에 의하면 마냥 깊어진다고 좋아지지는 않는다.

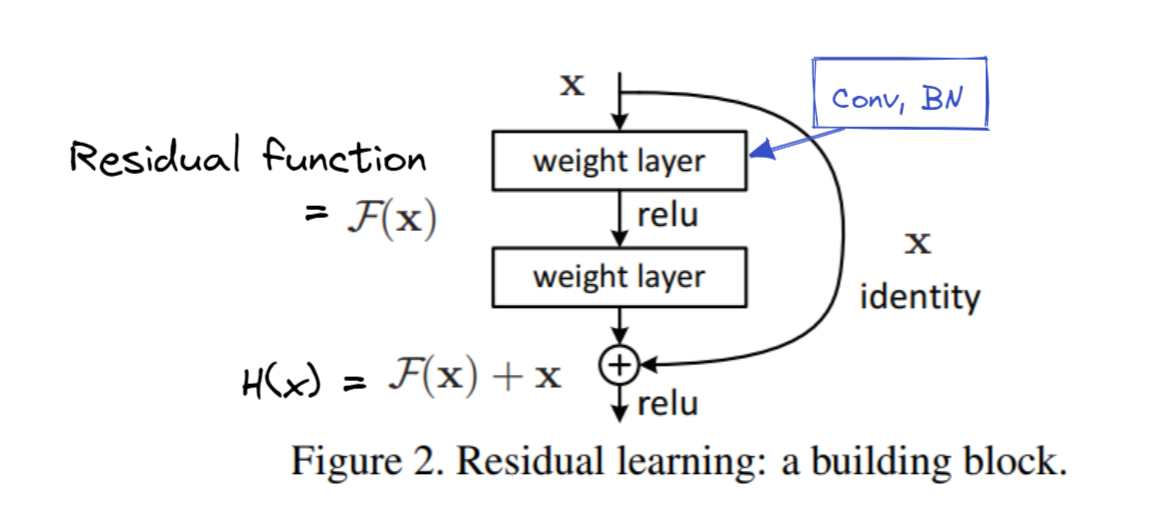

Residual block

논문에서는 skip connection 방법을 제시한다.

- 즉 하나 혹은 여러 개의 layer를 건너뛴다.

직접 규제를 통해 F(x)를 조절하는 것보다 이 방법을 이용하는 것이 편하다.

- 만약 x 연결 부분이 강해지면 레이어를 거의 스킵해버림

Gradient cal

- = gradient highway

- mitigate vanishing gradients 역할을 함

- 그래디언트 값을 직접적으로 이전 레이어에 전달

Skip connections

Identitiy shortcuts : 차원이 같을 때 사용

차원이 다르면

- zero entries padding을 통해 차원을 맞춘다.

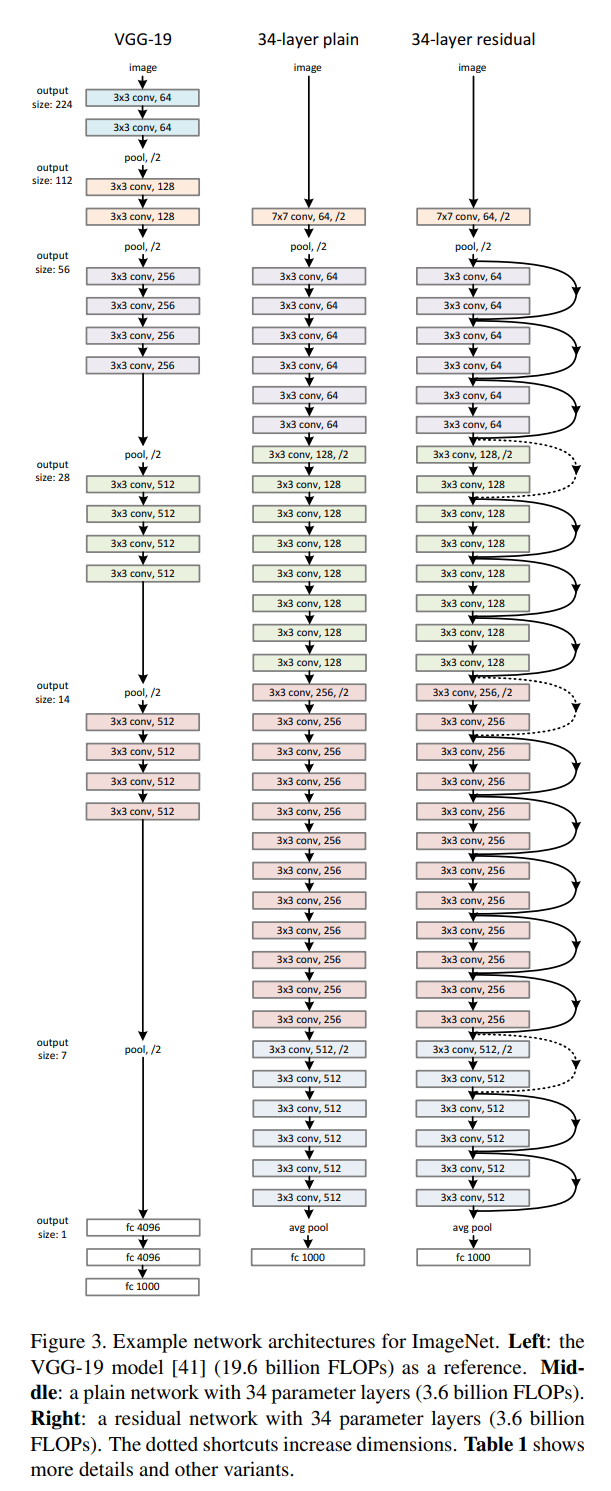

Deep Residual Net

- 3번 줄과 같은 아키텍쳐를 가진다.

- 효과는 좋다고 한다